Configuración inicial del entorno de desarrollo con Python y AWS Bedrock

En este artículo aprenderás a crear, configurar y validar un entorno de desarrollo Python listo para consumir los modelos de IA de AWS Bedrock. Incluimos ejemplos de código, comparativas con alternativas del mercado y una sección completa de buenas prácticas, seguridad y troubleshooting.

1. Requisitos previos

- Cuenta activa en AWS con permiso

bedrock:InvokeModely acceso a Bedrock. - Python 3.9 o superior instalado en tu máquina (se recomienda Python oficial o pyenv).

- Herramientas de línea de comandos:

aws-cli(v2) ygit. - Conexión a internet sin restricciones de salida a los endpoints de

bedrock-runtime.*.amazonaws.com.

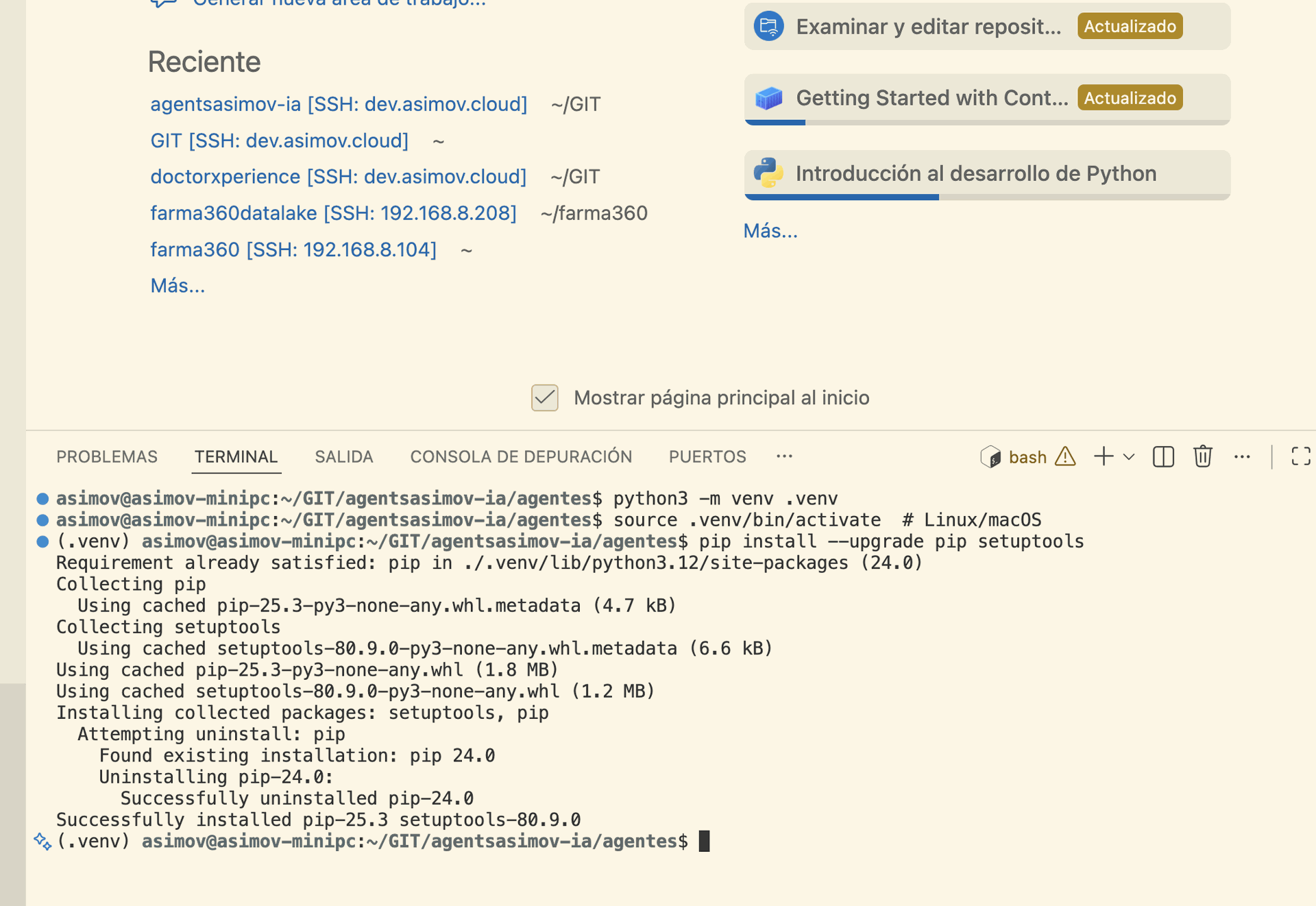

2. Configuración del entorno virtual

Crear un entorno aislado garantiza reproducibilidad y evita conflictos de dependencias.

python -m venv .venv

source .venv/bin/activate # Linux/macOS

.\\venv\\Scripts\\activate # Windows Actualiza pip y setuptools antes de instalar paquetes.

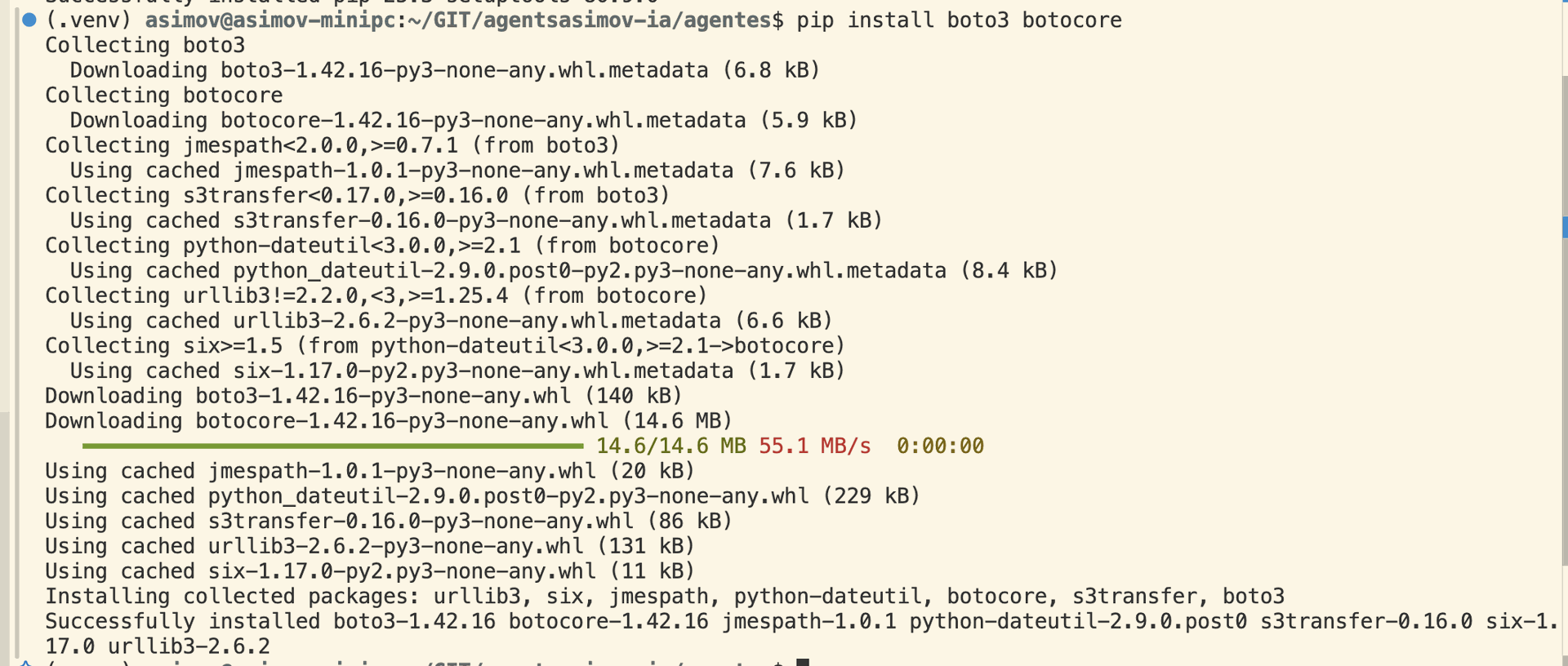

pip install --upgrade pip setuptools3. Instalación del SDK de AWS para Python (boto3) y dependencias de Bedrock

pip install boto3 botocore

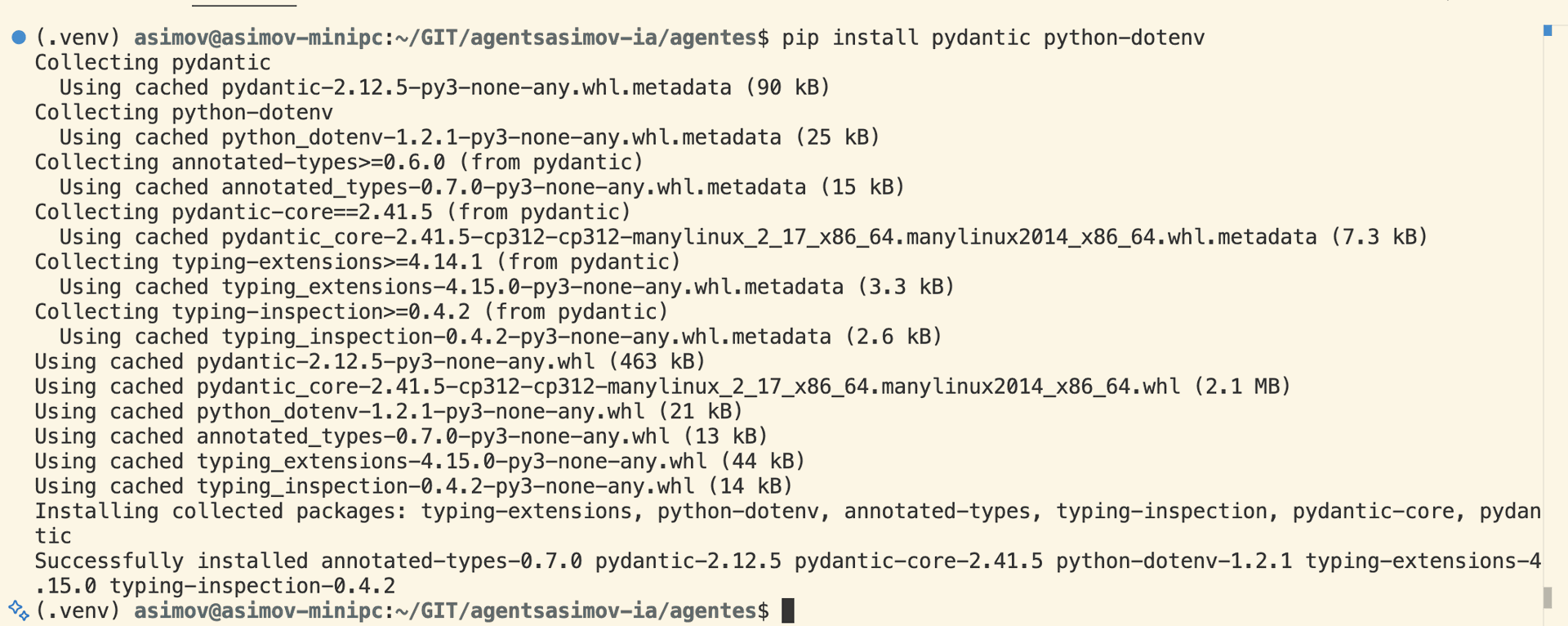

Para simplificar la serialización JSON de los payloads, también instalaremos pydantic y python-dotenv para gestionar variables de entorno.

pip install pydantic python-dotenv4. Configuración de credenciales AWS

Utiliza el comando oficial de la CLI para crear el archivo ~/.aws/credentials y ~/.aws/config con tu Access Key y Secret Key.

aws configure

# AWS Access Key ID [None]: YOUR_ACCESS_KEY

# AWS Secret Access Key [None]: YOUR_SECRET_KEY

# Default region name [None]: us-east-1

# Default output format [None]: jsonPara entornos CI/CD, se recomienda usar IAM Roles o AWS Secrets Manager en lugar de credenciales estáticas.

5. Primer ejemplo práctico: Generar texto con el modelo Claude 2 en Bedrock

El siguiente script muestra cómo invocar un modelo de lenguaje mediante boto3. El código está estructurado con Pydantic para validar la solicitud y la respuesta.

Guarda este script como generate_text.py y ejecútalo con python generate_text.py. Deberías obtener una respuesta en menos de un segundo.

6. Comparativa de modelos de IA: AWS Bedrock vs competidores

AWS Bedrock (selección de modelos)

- Claude 2 (Anthropic) – enfoque en razonamiento y seguridad.

- Jurassic‑2 (AI21) – generación de texto larga y coherente.

- Llama 2 (Meta) – modelo abierto, configurable.

- Amazon Titan – modelo nativo, optimizado para AWS.

- Facturación por token consumido, sin cargos de infraestructura.

- Integración nativa con IAM, VPC endpoints y CloudWatch.

OpenAI / Azure OpenAI

- GPT‑4 / GPT‑3.5 – modelo de referencia en el mercado.

- Precios basados en tokens de entrada y salida, con capas de suscripción.

- Seguridad a través de Azure AD y Private Link (Azure OpenAI).

- Mayor ecosistema de herramientas y plugins.

- No está integrado directamente con los servicios de AWS (requiere VPC peering o internet).

- Limitaciones de región y disponibilidad de modelos.

7. Buenas prácticas de seguridad

- IAM least‑privilege: Crea una política específica que solo permita

bedrock:InvokeModelsobre los modelos que vas a usar. - Uso de VPC Endpoints: Evita que el tráfico salga a internet utilizando

com.amazonaws.como endpoint privado..bedrock-runtime - Encriptado de datos en reposo: Si almacenas prompts o respuestas en S3, habilita SSE‑S3 o SSE‑KMS.

- Rotación de credenciales: Configura rotación automática con AWS Secrets Manager.

- Auditoría: Habilita CloudTrail para registrar cada

InvokeModely configura alarmas en CloudWatch para patrones anómalos.

8. Optimización de rendimiento y escalabilidad

- Batching de solicitudes: Cuando necesites generar respuestas para cientos de prompts, agrúpalos en lotes de 5‑10 para reducir la latencia.

- Control de

max_tokensytemperature: Ajusta estos parámetros para equilibrar calidad vs coste. - Parallelismo con asyncio: Usa

aioboto3para lanzar múltiplesinvoke_modelen paralelo. - Cache de resultados: Implementa Redis o DynamoDB para almacenar respuestas a prompts repetidos.

- Monitoreo: Registra latencias y uso de tokens en CloudWatch Metrics y crea dashboards de capacidad.

9. Resolución de problemas comunes

| Problema | Causa típica | Solución recomendada |

|---|---|---|

| 403 Forbidden | Política IAM insuficiente | Agregar bedrock:InvokeModel a la política del rol/usuario. |

| Timeout al invocar el modelo | Endpoint VPC no configurado o latencia de red | Verificar VPC endpoint, aumentar readTimeout o usar zona de disponibilidad cercana. |

Respuesta vacía o null | Formato de payload incorrecto | Validar JSON con Pydantic o herramientas como jq. |

| Costos inesperados | Uso excesivo de max_tokens o bucles infinitos | Implementar límites de tokens y auditoría diaria de CloudWatch. |

10. Integración en pipelines CI/CD

Ejemplo de integración con GitHub Actions que ejecuta pruebas unitarias contra un modelo de Bedrock de bajo costo (por ejemplo, amazon.titan-text-lite-v1).

name: Test Bedrock Integration

on: [push, pull_request]

jobs:

bedrock-test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Python

uses: actions/setup-python@v5

with:

python-version: '3.11'

- name: Install dependencies

run: |

python -m venv .venv

source .venv/bin/activate

pip install -r requirements.txt

- name: Configure AWS credentials

uses: aws-actions/configure-aws-credentials@v3

with:

aws-access-key-id: ${{ secrets.AWS_ACCESS_KEY_ID }}

aws-secret-access-key: ${{ secrets.AWS_SECRET_ACCESS_KEY }}

aws-region: us-east-1

- name: Run Bedrock test

env:

MODEL_ID: amazon.titan-text-lite-v1

run: |

source .venv/bin/activate

python - Conclusión

Configurar un entorno de desarrollo con Python y AWS Bedrock es rápido, seguro y altamente escalable. Siguiendo las mejores prácticas de IAM, uso de VPC endpoints y monitoreo, puedes integrar modelos de IA avanzados en aplicaciones web, microservicios o pipelines de datos sin preocuparte por la infraestructura subyacente. Además, la comparativa con OpenAI y Azure OpenAI muestra que Bedrock ofrece una integración profunda con el ecosistema AWS, lo que lo convierte en la opción preferida para organizaciones ya invertidas en la nube de Amazon.